미래를 예측하는 법

How To Predict The Future

2024년에 인간 수준의 AI가 나타난다고 예측한 2012년에 작성된 글을 우연히 읽게 되었습니다. 글에 따르면 2030년에는 뇌에 컴퓨터를 이식할 수 있게 된다고 합니다.

어떻게 2012년에 인간 수준의 AI가 언제 나타날지 예측할 수 있었던 걸까요?

오늘은 하드웨어 발전 추세를 통해 소프트웨어 기술이 언제 나타날지 예측하는 방법을 정리한 William Hertling의 How To Predict The Future를 번역했습니다.

미래를 예측하는 법

미래를 확실하게 예측하는 방법이 있다면, 누구나 원할 겁니다. 어쩌면 지금 투자할 스타트업을 고민하고 있거나, 회사의 리소스를 어디에 집중할지 결정해야 하는 상황일 수도 있습니다. 아니면 단순히 10년, 20년, 30년 후 세상이 어떻게 변할지 궁금한 것일 수도 있고요.

미래를 논리적으로 사고하고, 아이디어를 발굴하고, 새로운 기술이 언제 등장할지 예측하는 기법은 여러 가지가 있습니다.

그중 제가 직접 써보고 효과를 본 방법 하나를 공유하려 합니다. 여러 차례 정확하게 들어맞았고, 작가로서 가까운 미래를 배경으로 한 테크노스릴러를 쓸 때도 같은 방법을 활용했습니다. 이야기는 1994년으로 거슬러 올라갑니다.

스트리밍 비디오 예측, 그리고 스프레드시트의 탄생

정보 기술의 미래를 예측하는 데는 크게 두 가지 관점이 있는 것 같습니다. 소프트웨어를 보는 쪽과 하드웨어를 보는 쪽. 제 생각에는 하드웨어 추세를 보는 것이 언제나 더 단순하고 정확합니다.

지금부터 할 이야기는 제가 거의 20년 가까이 관리해 온 스프레드시트에 관한 것입니다.

1990년대 중반, 저는 절친한 친구인 Gene Kim(Tripwire 창업자이자 When IT Fails: A Business Novel의 저자)과 함께 애리조나 대학교 컴퓨터공학과 대학원에 다니고 있었습니다. 당시 우리가 연구하던 큰 기술적 난제 중 하나는 네트워크를 통해 스트리밍 비디오를 전송하는 것이었습니다. 데이터를 보낼 대역폭도 부족했고, 비디오를 압축하고 해제할 처리 능력도 부족했기 때문에 어려운 문제였습니다. 비디오 압축 기술과 TCP/IP 양쪽 모두에서 개선이 필요했습니다.

재미있는 건, 아무리 점진적인 개선을 거듭해도(수십 명이 각기 다른 각도에서 이 문제에 매달리고 있었습니다) 스트리밍 비디오는 늘 ‘곧 실현될 것처럼’ 보였다는 점입니다. “내년이 바로 비디오의 해가 될 거야”와 비슷한 말을 몇 년에 걸쳐 수없이 들었습니다. 하지만 그런 일은 일어나지 않았습니다.

이 무렵 저는 스프레드시트를 하나 만들기 시작했습니다. 그동안 제가 소유했던 컴퓨터들의 정보를 모두 입력했습니다. 처리 능력, 하드 드라이브 용량, RAM 용량, 모뎀을 기록했습니다. 그런 다음 각 항목의 연평균 증가율을 계산하고, 이를 미래 시점으로 연장해 나갔습니다.

저는 “모뎀 속도”(당시 제가 그렇게 불렀던 것으로, 오늘날에는 인터넷 연결 속도나 대역폭이라고 부릅니다)의 미래 예측치를 살펴봤습니다. 이 즈음 저는 스트리밍 비디오가 곧 실현될 거라는 말에 지칠 대로 지쳐 있었고, 소프트웨어 압축 기술의 발전을 예측하려는 시도는 접기로 했습니다. 그냥 하드웨어 추세만 보기로 한 겁니다. 하드웨어 추세에 따르면 인터넷 연결 속도는 계속 증가하고 있었고, 2005년쯤이면 무리한 수준의 비디오 압축이나 인터넷 프로토콜의 기적에 기대지 않고도 실시간으로 비디오를 스트리밍할 수 있을 만큼 속도가 충분해질 터였습니다. Gene Kim은 제 예측을 듣고 웃었습니다.

9년 후인 2005년 2월, 유튜브가 등장했습니다. 스트리밍 비디오가 마침내 현실이 된 겁니다.

같은 스프레드시트는 음악 다운로드 서비스가 1999년이나 2000년에 나타날 것이라고도 예측했습니다. 최초의 P2P 음악 공유 서비스인 냅스터가 등장한 건 1999년 6월이었습니다.

이 데이터는 장기적으로도 놀라울 만큼 정확했습니다. 1986년에 쓰던 모뎀과 1998년에 쓰던 모뎀, 단 두 개의 데이터만으로 스프레드시트는 2012년에 제가 25Mbps 연결을 쓰게 될 거라고 예측했습니다. 현재 저는 30Mbps 연결을 쓰고 있으니, 15년 예측치고는 상당히 정확한 셈입니다.

이 방식이 작동하는 이유 Part 1: 선형 vs. 비선형

당시에는 이 개념을 제대로 이해하지 못했지만, 돌이켜보면 제가 한 일은 이런 것이었습니다. 선형적 추세(시간이 지나면서 완만하게 진행되는 발전)를 활용해 비선형적 사건(기술적 격변)의 시점을 예측한 것입니다. 기반이 되는 하드웨어가 돌파구를 열어줄 시점을 계산하는 방식으로요. 앞서 “소프트웨어 발전을 예측하려는 시도는 접고, 그냥 하드웨어 추세만 보기로 했다”고 한 게 바로 이런 뜻입니다.

물론 미래에 어떤 발전이 일어날지 상상하는 일은 여전히 필요합니다(추세가 아이디어에 영감을 줄 수는 있지만요). 이 기법이 해주는 건, 아이디어를 기반 요건에 대입해서 언제 실현될지 파악하게 해주는 것입니다.

예를 들어, 이런 질문들에 답할 수 있습니다:

– 자기 플래터 방식의 하드 드라이브는 언제 마지막으로 생산될까? 2016년. 2006년쯤 자기 플래터 하드 드라이브와 플래시 드라이브의 용량 증가 추세를 그려봤더니, 2016년에 플래시가 자기 매체를 추월하는 것으로 나왔습니다.

– 범용 컴퓨터가 뇌에 이식할 수 있을 만큼 작아지는 건 언제일까? 2030년. 컴퓨터의 지속적인 소형화 추세에 따르면 2030년쯤이면 컴퓨터 한 대가 연필 지우개 크기가 될 것이고, 그 정도면 이식이 어렵지 않습니다.

– 범용 컴퓨터가 인간 수준의 지능을 시뮬레이션할 수 있게 되는 건 언제일까? 2024년에서 2050년 사이. 인간 지능의 복잡성을 어떻게 추정하느냐, 그리고 시뮬레이션에 컴퓨터를 몇 대나 투입하느냐에 따라 달라집니다.

잠깐, 2024년에 인간 수준의 인공지능이라고요? Gene Kim이라면 이 말에도 웃을 겁니다. AI가 얼마나 어려운 분야인데요. 인공지능이 곧 실현될 거라는 예측, 40년째 반복되고 있지 않나요?

이 방식이 작동하는 이유 Part 2: 크라우드소싱

SXSW에서 인공지능의 미래를 주제로 한 패널에 참여했을 때, 함께 패널로 나온 한 분이 이의를 제기했습니다. 컴퓨터 성능의 기하급수적 성장만으로 컴퓨터에서 인간 수준의 지능을 개발하기에 충분하다는 생각에 동의할 수 없다는 것이었습니다. 인공지능에는 매우 어려운 문제들이 있고, 그 문제들 하나하나가 대단히 뛰어난 연구자들의 노력을 필요로 한다고요.

틀린 말은 아닙니다. 하지만 세상은 넓고 뛰어난 사람은 많습니다. 오픈소스와 크라우드소싱의 원리는 이미 잘 알려져 있습니다. 충분히 많은 뛰어난 사람들이 한 문제에 매달리면, 특히 열린 방식으로 협력하면, 진전은 빠르게 찾아옵니다.

저는 IEEE Spectrum에 The Future of Robotics and Artificial Intelligence is Open이라는 글을 쓴 적이 있습니다. 그 글에서 취미 개발자 커뮤니티가 저렴한 무인 항공기 자동 비행 하드웨어와 소프트웨어를 만들어내고 있는 현상을 분석했습니다. 한때 연구소의 숙련된 연구자들이 2만 달러를 들여 만들던 것을, 이제는 취미 개발자들이 파트타임으로 500달러에 만들어냅니다.

하드웨어가 충분히 강력해지면, 발명은 가능해집니다. 그 이전에는 불가능합니다. 모터 없이 자동차를 만들 수 없는 것처럼요.

그리고 그 강력한 하드웨어가 널리 보급되면, 발명은 필연이 됩니다. 크라우드소싱의 영역에 들어서기 때문입니다. 이제 수백, 수천 명이 기여할 수 있게 됩니다. 충분히 많은 사람이 음악을 공유할 만큼 충분한 대역폭을 갖게 되었을 때, 누군가 어딘가에서 온라인 음악 공유를 발명하는 건 필연이었습니다. 냅스터는 단지 그중 첫 번째였을 뿐입니다.

미국 퀴즈쇼 Jeopardy에서 우승한 IBM의 왓슨은 300만 달러어치 하드웨어로 만들어졌고 2,880개의 프로세싱 코어를 사용했습니다. 같은 수준의 컴퓨팅 파워가 개인용 컴퓨터에서 가능해지면(대략 2025년쯤), IBM 연구팀만 고급 AI를 가지고 노는 게 아니게 됩니다. 전 세계 수십만 명의 AI 애호가들이 왓슨에 필적하는 오픈소스 프로젝트에 기여하게 될 겁니다. 그때가 되면 AI는 정말로 날개를 달 겁니다.

(그렇게 많은 사람이 관심을 가질까 의심된다면, 스탠퍼드의 무료 AI 강좌에 10만 명 이상이 등록했다는 사실을 떠올려보세요. 머신러닝/구글 자율주행차 강좌에도 비슷한 수가 등록했습니다.)

물론 이 기법이 모든 종류의 혁신에 통하는 건 아닙니다. 위키피디아는 지식 큐레이션 방식에 있어 엄청난 발명이었고, 그 자체가 위키라는 발명에 의존하고 있었습니다. 하지만 사후적으로 돌아봐도 위키피디아를 예측할 수 있었다고 말하기는 어렵습니다. 언제 등장할지 예측하는 건 더더욱요.

(대중이 큐레이션하는 온라인 지식 시스템이라는 아이디어가 있었다면, 인터넷 연결 속도라는 리트머스 테스트를 적용해서 충분한 기여자와 사용자가 확보되는 시점을 가늠해볼 수는 있었을 겁니다. 위키 같은 문서 시스템은 접속할 방법이 없으면 무용지물이니까요. 하지만 이건 여담이고…)

이의 있습니다, 재판장님

흔히 제기되는 반론은 이겁니다. 이런 성장이 영원히 계속될 리 없다, 결국 근본적인 한계에 부딪힐 것이다. 컴퓨터 처리 속도만 봐도 실리콘 제조 한계, 열 방출 한계, 신호 전파 한계 등이 있지 않냐는 겁니다.

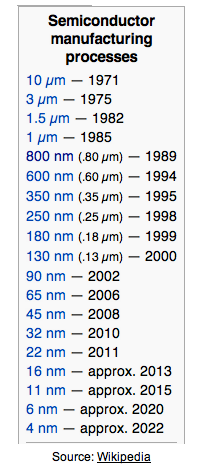

이런 류의 주장을 처음 읽은 게 1980년대 중반, 인텔 80386 프로세서에 관한 글이었던 걸로 기억합니다. 당시 칩 제조에 800nm 공정을 사용하고 있는데, 곧 근본적인 한계에 도달해서 더 이상 작게 만들기 어려울 거라는 내용이었습니다. (프로세서 기술에서는 작을수록 빠릅니다.)

하지만 제조 기술은 계속해서 더 작아져 왔습니다. 한계는 극복되거나, 우회되거나, 기술 전환으로 해결됩니다. 오랫동안 처리 능력의 향상은 대부분 클럭 속도의 증가 덕분이었습니다. 그 방식이 한계에 부딪히기 시작하자, 병렬화를 통해 속도를 높이는 방향으로 전환했습니다. 더 많은 프로세싱 코어, 코어당 더 많은 실행 스레드를 사용하는 식으로요. 미래에는 그래핀 프로세서나 양자 프로세서가 등장할 수도 있습니다. 하지만 기반 기술이 무엇이든, 속도는 대략 같은 비율로 계속 증가할 가능성이 높습니다.

미래 예측이 유용한 이유: 예측과 검증

저는 이 기법을 두 가지 방식으로 활용합니다. 첫째는 브레인스토밍의 씨앗으로 쓰는 것입니다. 선형적 추세를 연장해보고 기술이 어디로 향하는지 확실히 파악하면, 그 기술로 무엇이 가능해질지 자유롭게 상상할 수 있게 됩니다.

예를 들어, 저는 신경 임플란트 기술을 진지하게 생각해본 적이 없었습니다. 물리적 크기 추세 차트를 보고 신경 임플란트가 가까운 미래에 실현 가능하리라는 걸 깨닫기 전까지는요. 그리고 기술적으로 가능하다면, 그건 사실상 필연입니다.

어떤 OS를 돌리게 될까? 신경 앱은 어느 앱스토어에서 받게 될까? 우리 뇌의 광고 공간은 누가 팔게 될까? 동전 크기의 초강력 컴퓨터로 또 뭘 할 수 있을까?

둘째는 다른 사람들의 주장을 검증하는 데 쓰는 것입니다. Lifenaut라는 회사가 있는데, 사람들의 데이터를 보관해서 사후 인격 시뮬레이션을 제공하겠다는 곳입니다. 대단히 매력적인 아이디어지만, 1994년의 비디오 스트리밍과 비슷한 상황입니다. 하드웨어가 아직 거기까지 안 됐습니다. 인간 수준의 AI가 가장 빨라야 2024년이고, 그것도 1,000대 이상의 컴퓨터 클러스터에서나 가능하다면, Lifenaut가 그 전에 현실적인 인격 시뮬레이션을 제공하기는 불가능해 보입니다.* 반면, 15년간 이 프로젝트를 지속할 의지가 있다면, 필요한 성능이 갖춰졌을 때 최고의 위치에 있게 될 수도 있습니다.

최근 ‘SF와 과학적 사실’ 패널에서, 다른 패널리스트들과 청중 대부분은 강인공지능이 50년은 남았고 뇌 증강 기술은 100년은 더 있어야 한다고 생각했습니다. 그렇게 먼 미래라면, 지금 생각할 필요가 없는 것들이 되어버립니다. 좀 위험한 태도 같습니다.

* 흔히 제기되는 반론은 “소프트웨어로 구현하면 자연이 뇌에서 구현한 것보다 훨씬 효율적일 것이다”입니다. 글쎄요, 저는 수백만 년의 진화에 베팅하겠습니다.

How To Do It

이 글의 제목이 미래를 예측하는 법 이니, 이제 본격적으로 방법을 다룰 차례입니다. 스프레드시트 계산과 공식을 몇 가지 보여드리겠지만, 꽤 간단하니 걱정하지 마세요. 과정은 세 단계로 나뉩니다. 기술 추세의 연간 증가율을 계산하고, 선형 추세를 미래로 연장한 다음, 미래의 격변을 그 추세에 대입하는 것입니다.

Step 1: 연간 증가율 계산

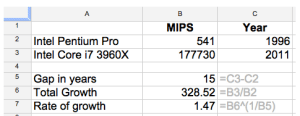

데이터 포인트 두 개만 있어도 이 작업이 가능하고, 꽤 신뢰할 만합니다. 1996년 컴퓨터와 2011년 컴퓨터, 두 대의 개인용 컴퓨터를 사용한 예시를 보겠습니다. 셀 B7을 보면 컴퓨터 처리 능력이 MIPS(초당 백만 명령어) 기준으로 15년간 매년 1.47배씩 증가했음을 알 수 있습니다.

저는 어딘가 연구소에서만 쓰는 기술보다 제가 직접 가진 기술과 관련된 데이터를 사용하는 걸 선호합니다. 물론 개인용 컴퓨터보다 훨씬 강력한 슈퍼컴퓨터도 있지만, 저는 그런 걸 가지고 있지 않고, 더 중요한 건 그런 기술은 크라우드소싱의 대상이 아니라는 점입니다.

또한 웹에서 비슷한 데이터를 찾아볼 수 있는데도 직접 계산하는 걸 선호합니다. 같은 기본 원리를 다양한 특성에 적용할 수 있기 때문입니다.

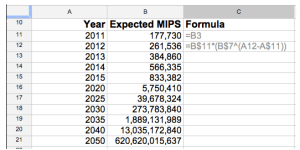

Step 2: 선형 추세 연장

두 번째 단계는 기술 추세를 시간에 따라 미래로 연장하는 것입니다. 여기서는 연간 증가율(B$7 – 앞의 스크린샷 참조)을 경과 연수만큼 거듭제곱한 뒤, 기준값(B$11)을 곱합니다. 셀 C12에 표시된 공식이 핵심입니다.

추세처럼 보이는 것이 진짜 추세인지 확인하기 위해 sanity check도 해보는 걸 좋아합니다. 방법은 이렇습니다. 과거의 데이터 포인트 두 개를 고릅니다. 하나는 신뢰할 만한 데이터가 있는 가장 오래된 시점, 다른 하나는 그 시점과 현재의 중간 지점입니다. 그런 다음 예측을 돌려서 현재 시점의 예측값이 실제와 얼마나 가까운지 봅니다. 대역폭 예시에서 1986년과 1998년의 데이터를 골랐더니, 2012년의 대역폭을 정확히 예측했습니다. 이상적인 경우입니다.

Step 3: 비선형적 사건을 선형 추세에 대입하기

마지막 단계는 격변을 가능하게 하는 기술에 대입하는 것입니다. 스트리밍 비디오 예시의 경우, 저는 최소 품질의 비디오 신호가 가로 320픽셀 × 세로 200픽셀 × 초당 16프레임, 픽셀당 최소 1바이트로 구성된다는 걸 알고 있었습니다. 비디오 압축은 현실적으로 달성 가능한 수준을 가정했습니다. 압축된 비디오 신호가 비압축 크기의 20%(5배 감소)가 되는 정도요. 이 가정에 기반한 기반 요건은 약 1.6Mb/초의 대역폭이었고, 2005년에 도달할 것으로 나왔습니다.

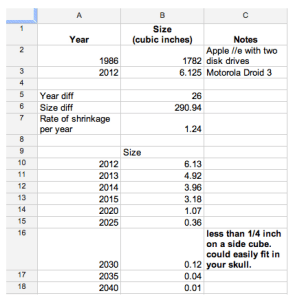

이식형 컴퓨터의 경우, 연필 지우개 크기(1/4인치 정육면체)의 컴퓨터라면 사람의 두개골에 쉽게 삽입할 수 있을 거라고 가정했습니다. 컴퓨터의 물리적 크기 추세를 보면, 2030년쯤 이 수준에 도달합니다:

이건 까다로운 예측입니다. 전통적인 데스크톱 컴퓨터는 하드 드라이브, 광학 드라이브, 전원 공급 장치 같은 부품들의 표준화된 폼 팩터에 제약을 받아 큰 사각형 박스 형태를 유지해왔기 때문입니다. 저는 당시 기준으로 컴팩트하게 설계된 컴퓨터들을 사용했습니다. 또한 1996년 Toshiba Portege 300CT를 sanity check용으로 선택했는데, Apple //e와 Portege 사이의 추세를 연장하면 제 Droid는 약 1세제곱인치여야 하는데 실제로는 6입니다. 그래서 이상적인 예측은 아니지만, 대략적인 방향과 시점을 가늠하는 데는 여전히 도움이 됩니다.

인간 수준 AI 예측은 더 직관적이지만, 표시하기는 더 어렵습니다. 인간 지능을 시뮬레이션하는 게 얼마나 어려울지에 대한 가정의 범위가 있고, 문제에 투입할 수 있는 컴퓨터 수에 따른 예측의 범위도 있기 때문입니다. 세 가지 요소(시간, 뇌의 복잡성, 사용 가능한 컴퓨터)를 결합하면 깔끔한 x-y 그래프가 나오지 않지만, 인간 수준 AI 스프레드시트 전체를 공개해두었으니 살펴보실 수 있습니다.

마지막으로 몇 가지 중요한 주의사항을 남기겠습니다:

– 세상 모든 것이 기하급수적으로 개선되지는 않습니다.

– 시간이 지나면서 일관되게 보이는 추세도 한계에 부딪힐 수 있습니다. 예를 들어, 1800년대 신규 토지 정착 속도(시간이 지나면서 증가하던 추세)가 무한히 계속될 수 없다는 건 분명합니다. 토지는 유한하니까요. 하지만 진짜 물리적 한계(예: 남은 정착 가능 토지)와 한계처럼 보이는 것(예: 컴퓨터 프로세서의 제조 한계)을 구별할 필요가 있습니다.

– 어떤 추세는 부정적 피드백 루프에 부딪힙니다. 1890년대 후반, 모든 개인 및 화물 운송이 말에 의존하던 시절에 말똥 위기가 있었습니다. (Gotham: The History of New York City to 1898을 읽어보세요.) 당시 추세를 그래프로 그렸다면, 곧 뉴욕 같은 도시가 말똥에 파묻힐 판이었습니다. 물론 이건 부정적 피드백 루프입니다. 말똥이 계속 늘어났다면 어느 시점에 사람들이 도시를 떠났을 테니까요. 결과적으로 자동차가 이 문제를 해결하고 도시가 계속 성장할 수 있게 해주었습니다.

이 기법은 기술의 일부 영역에서만 작동하고, 언제나 상식을 적용해야 한다는 점을 염두에 두세요. 저는 정보 기술 예측에만 사용해봤지만, 다른 분야에 적용한 사례가 있다면 듣고 싶습니다.